“安全是最大的豪华。”何延哲抛出这句出自新能源汽车圈的口号,提醒AI行业的从业者:在安全问题上稍有失足,有可能导致满盘皆输。

何延哲来自中国电子技术标准化研究院,长期关注网络安全。他在12月18日南都“第九届啄木鸟数据治理论坛”上表示,安全性的价值在于,把好用的AI产品变得让公众敢用。

2025年,AI加速向物理世界渗透。从可以拍照和“看一下支付”的AI眼镜,到能够自主点外卖的AI手机,再到准备去工厂、进家庭的具身智能机器人,AI应用落地的想象空间被打开。

当许多人沉浸于技术变革带来的新奇感时,一些网络安全的从业者则追问和验证:炫酷的AI产品究竟安全可靠吗?

12月18日,南都“第九届啄木鸟数据治理论坛”的圆桌讨论环节。图:南都

具身智能安全防护机制“千疮百孔”

对AI硬件产品的安全测试结果并不乐观。

网络安全研究机构DARKNAVY·深蓝的肖轩淦提到,利用安全缺陷,植入攻击代码,就能让一款市面上热门AI眼镜变成“无感偷拍”的工具。部分眼镜的“看一下支付”功能,基于采集用户语音并通过声纹匹配来核验转账。但如果攻击者利用智能眼镜的安全缺陷,取得其完全控制权,可能可以窃取并伪造用户声纹,暗中完成转账支付。

肖轩淦和团队成员还对具身智能机器人做过安全测试,他形容该行业的安全防护现状可谓“千疮百孔”。某些机器人中存在多种安全缺陷,可以被攻击者劫持,对外在对象做出攻击性动作。

“如果机器人打了人,这一拳下去打破的将是一个产业。”何延哲认为,如果发生这样的事故,民众对产品的态度会发生巨大的转变,各种各样的非议也将随之而来。

2025年10月24日的“GEEKCON2025”安全极客大赛现场,安全研究员操控某品牌机器人攻击假人。图:活动主办方

然而,肖轩淦发现,许多AI新兴领域的创业公司,对安全价值的理解认知缺位严重。此前第三方白帽黑客向厂商报告安全漏洞,部分厂商对此漠然以对。他还留意到,被测试的智能眼镜厂商和具身智能公司,有的直到今年下半年才组建安全团队,有的迄今没有专门的产品安全团队。

肖轩淦认为,AI创业公司起步阶段,会把产品的功能作为优先目标,但是在发展过程中必须考虑把安全的基座筑牢、正确认识安全的价值。很多厂商将安全仅视为成本和负担。但事实上,把安全做好了也能成为一项核心竞争力、创造新的商业价值。某些头部企业已经用实际行动证实了这一点。

AI手机智能体,“一次突进”

12月以来,豆包助手掀起舆论风浪。这款AI手机助手先是撞上多家国民级App的“风控墙”,随后选择妥协,关闭对一些大厂旗下App的操作能力,以获取这些应用解除对设备登录的限制。

豆包助手引发的争议集中于两个方面:系统级操作权限的调用,对用户隐私安全的潜在风险有多高?当手机助手成为流量入口,又会如何搅动现有的互联网竞争格局?

在肖轩淦看来,豆包通过与手机厂商合作,摇身变成一款系统级超级应用,获取到了对应的系统级权限。由于手机系统已经提供了一定的基础防御能力,调用的这些权限也属于系统级应用的特殊权限,因此安全风险存在但总体可控。然而,没有绝对的安全,黑灰产依然有可能利用安全缺陷,侵害用户隐私,这需要手机厂商和智能体厂商不断提高安全防护壁垒。另外,在部分场景下,智能体背后的大模型需要在云端进行推理,“上云”的数据也有被攻击突破的隐患。

豆包助手发布后一周的12月8日,中国网络空间安全协会人工智能安全治理专委会专门召开“AI助手安全合规”研讨会。根据会议新闻稿,当天,有来自华为、小米、OPPO、vivo和抖音等单位的20余名专家参加。

中国网络空间安全协会人工智能安全治理专委会副秘书长夏文辉参与了这场内部研讨会。在前述南都的论坛上,夏文辉把豆包助手定义为由AI辅助向智能代理的“一次突进”:目前App厂商与豆包助手围绕着权限安全为表层逻辑所发生的矛盾,体现的是利益和生态的强烈摩擦,以及对合规的迫切诉求。

鉴于AI助手与端侧应用结合的大势所趋,夏文辉认为,对AI手机助手的监管既要避免“一刀切”地严管,又不能放任其野蛮生长。现有的法规及标准有待相应明确,也需要针对新的技术和应用补足政策法规。

熊定中为终端厂商和互联网企业这些手机智能体生态中的主体提供过法律服务。作为北京清律律师事务所首席合伙人,他从中看到不正当竞争的风险:有的App厂商在意的是,当用户发出指令,比如买咖啡或点外卖的时候,AI助手为何调取这款App,而不是调取另外一款App?如果用户没有清晰指定App,那么决策权就交给了手机助手。

流量入口转移导致智能体厂商和App厂商之间的博弈,但熊定中发现,用户意志在这场激烈讨论中缺位了。他认为,用户对于App内个人数据的权利究竟具有最高位阶,还是与App厂商处于平等地位,这仍是一个有待厘清的基础理论问题。

清洗AI标识的黑灰产隐现

AI安全风险不仅涉及像具身智能、AI眼镜、AI手机这些硬件产品的安全隐患,也关乎认知层面的安全——比如,保障用户对AI生成内容的知情权。

今年AI治理的一项监管重点是给AI内容“上身份”。3月中旬,《人工智能生成合成内容标识办法》对外发布,全国多个城市随后开展AI生成合成内容标识政策法规宣介活动。这项AI标识新规要求必须给AI生成的内容添加人眼可见的显式标识,以及不易被用户明显感知到的隐式标识。

何延哲表示,隐式标识不是给普通用户看的,而是给监管看的,主要用于追踪和识别滥用AI生成内容的情况。

MiniMax早在2024年就作为试点平台,参与了标识办法和配套强制性国家标准的技术验证,对添加标识方法进行了探索。MiniMax稀宇科技总编辑、副总裁彭韬认为,AI标识规定起草过程中,已充分吸纳了企业的意见,在技术实施难度、成本控制上具有可行性。

彭韬说,隐式标识的规定,一方面是为了满足监管要求,另一方面对企业自身而言,也将成为保障内容安全、版权与商业利益的有益手段。

南都12月18日发布的《生成式AI落地应用:透明度测评与案例分析报告(2025)》(下称《报告》)提到,强监管下,AI生成内容标识成标配,各家大模型在添加标识方面明显改进。

据夏文辉观察,拥有完备合规流程的大厂在AI标识落地上普遍做得不错。初创企业,特别是新生、规模小的企业的合规仍需要跟进落实。

但彭韬发现,实践中,已出现专门做清洗AI隐式标识的黑灰产团队,相关黑灰产从业者在社交平台群聊中传播这种清洗工具。

南都记者注意到,网络上出现一些打着“去除AI标识水印”旗号的工具。这些工具的提供商还声称可以通过清洗,让内容无法被AI检测工具识别到。

网络上一款宣称可以去除AI水印的工具网站。

彭韬还提到,隐式标识的技术本身仍存在不稳定性,在内容传播过程中易发生损耗。因此,要真正让AI标识的落地达到制度设计初衷,还有较长的路要走。

AI陪伴对青少年“不是洪水猛兽”

AI陪伴产品应用如雨后春笋般涌现,“虚拟陪伴”产业已然成型。但随着多起青少年自杀等极端案例出现,AI陪伴产品开发商陷入舆论漩涡,人机互动遭遇伦理考验。

前述南都《报告》梳理发现,目前已公开的诉讼涉及多个知名AI平台,其中以Character.AI和ChatGPT开发商OpenAI为主要被诉对象。涉诉AI平台被指控的行为主要集中在诱导自杀、教唆自残暴力与激化家庭矛盾、传播涉及性虐待与精神操纵的内容等类型。

国内在2025年也出现针对AI陪伴产品的监管案例。6月19日,知名AI陪伴产品“筑梦岛”App因生成低俗擦边内容,危害未成年人身心健康,被上海市网信办约谈。

极端案例驱动AI陪伴公司进行整改,比如上线防自残提示、检测自杀倾向,设置未成年人模式或直接取消对未成年人提供服务。

彭韬认为,AI技术不是洪水猛兽。对青少年来说,并不是一味地将其与AI产品隔离开就万事大吉。无论AI公司还是监管部门,更应该做的是告诉青少年如何正确使用AI,开展各类宣传和教育工作提升其AI素养。

在AI平台的青少年保护合规举措上,彭韬介绍称,MiniMax的做法大体可分为两方面:一方面,对未成年人模式、未成年人使用AI设置时间限制等传统的管理举措,公司“照单全收”;另一方面,利用AI能力、结合合规获取的用户数据,去分析用户的行为特征,从而尽可能地主动识别出未成年人群体。

记者注意到,MiniMax旗下的“星野”App设有未成年模式,开启之后,每日22点至次日6点的深夜时段禁止用户使用。

AI版权诉争胶着,如何寻找共赢路径?

前述南都“第九届啄木鸟数据治理论坛”的圆桌上,AI版权治理也是一项备受关注的话题。

从模型输入端到输出端,AI版权案件的争议集中在三个方面:其一,未经授权将版权保护的内容作为训练数据是否构成合理使用;其二,模型输出的内容是否侵犯既有内容的版权,及AI平台在当中的责任认定;其三,AI生成的内容能否受到版权法的保护。

生成式AI浪潮持续演进的过去三年里,上述第二项和第三项争议基本上有了较为明确的司法判断,尽管不同法院的观点可能存在差异。但关于输入端的侵权问题,产生实质性进展的案例依然少见。围绕着能否免费使用版权保护的内容,版权权利人与AI公司之间争论不休。

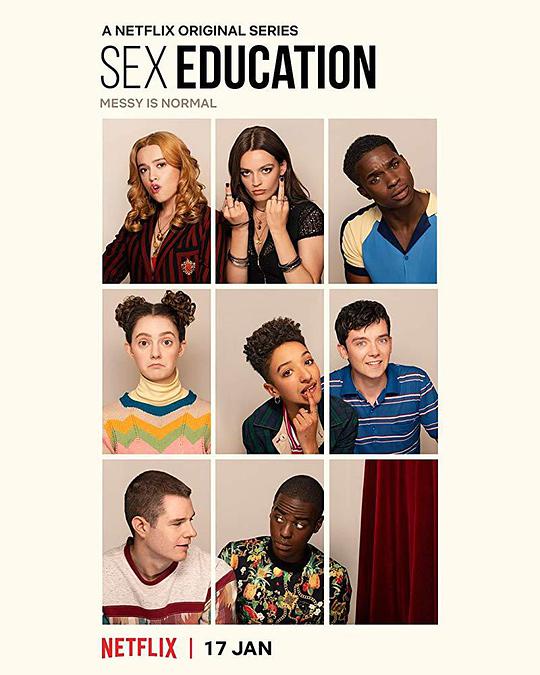

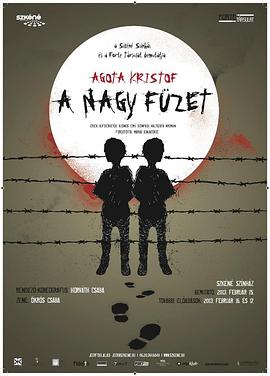

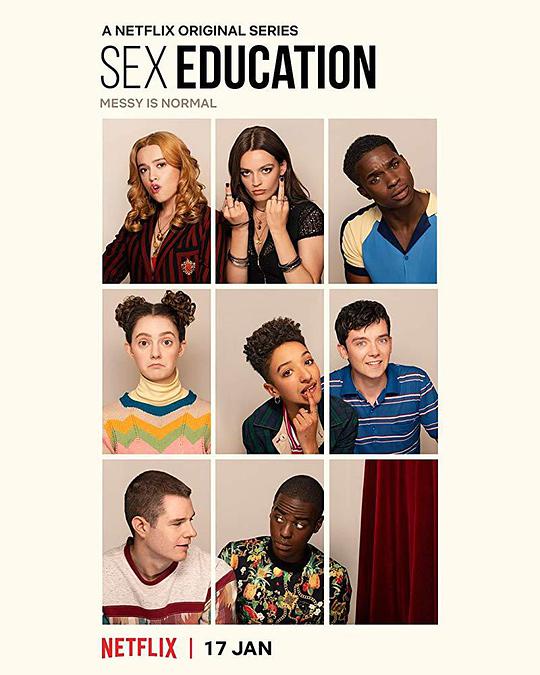

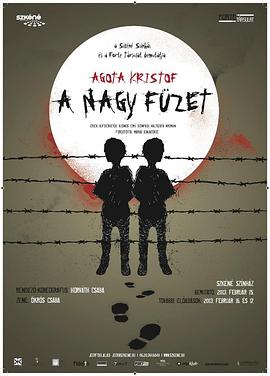

AI公司在美被诉版权侵权案件数量统计。图:南都《生成式AI落地应用:透明度测评与案例分析报告(2025)》

根据前述南都的《报告》统计,截至2025年11月18日,美国已至少发生56起AI版权的诉争。其中超过50起案件都涉及AI模型输入端和输出端版权侵权案例。而在中国,目前至少有两起AI训练数据版权案件在北京互联网法院审理。

熊定中是其中一起AI数据训练版权案件的代理律师。他和一些文艺创作者接触下来发现,这些群体之所以对AI恐慌,是担心AI生成的内容对既有作品产生“替代性效应”,“著作权人感受到的是毁灭性的打击”。

AI公司和一些法律专家则认为,若严格按照传统的授权许可使用机制,由于训练数据规模海量,不仅授权执行难度大,而且还可能导致授权费用过高而阻碍AI产业的发展。版权人与AI公司持续拉扯下,如何平衡二者的利益成为迫切课题。

熊定中认为,无论是立法还是司法,都应当确保AI公司给予相关经济上的对价,不管是以赔偿还是补偿的名义。当然,这种对价到底如何衡量和定价,依然是后续的棘手难题。

彭韬提到,现实的瓶颈在于:AI公司对于高质量数据具有明确需求,但如何保障企业充分合规获取优质数据以推动技术发展,无论是政策法规还是市场机制都需要进一步创新突破。“作为企业,我们希望可以没有顾虑地合规获取数据资源,但是人工智能技术对于数据要素的生产利用有其独特性,目前传统数据保护和版权保护机制还存在一些无法完全匹配的地方,期待各方共同探索解决”。

在接连不断的AI版权纠纷当中,一些案件已达成和解,“以诉促和”的做法越发明显。比如10月下旬以来,华纳音乐、环球音乐等知名音乐厂牌结束与Suno和Udio这两家AI音乐平台的诉争。和解的前提是签订授权许可协议。

另外,还有版权方和AI公司在未发生诉讼的情况下主动开展授权合作。12月11日,迪士尼与OpenAI达成10亿美元的股权投资,并将旗下200多个动漫角色授权给后者的Sora使用。据报道,OpenAI不用向迪士尼缴纳现金授权费,而是以股票认股权证的形式支付对价。

彭韬赞赏迪士尼与OpenAI的合作范式,认为这是一起典型的实现共赢的案例。

“通过IP授权、创作分成等多元化市场手段代替司法诉讼,这可能是更有利于AI企业和技术发展的一条道路,也可以为数据版权方拓展更丰富的市场应用模式。我们也希望能跟数据提供方形成利益共享的良性合作机制。”彭韬建议,可以在有关部门指导下,联合AI公司、版权提供方和数据交易机构等多方主体,针对一些现有法律规则尚不明确的环节开展沙盒试点,共同探索解决方案,打造示范案例。

出品:南都数字经济治理研究中心

采写:南都N视频记者 杨柳 发自北京